Prije nekoliko dana, Meta (Facebook) je najavila ‘osobnog AI asistenta’ (slično i Google) koji će biti svjestan svih dostupnih informacija o osobi iz prošlosti, a potom i u realnom vremenu. Vrlo brzo, pomoćnik će znati više o osobi nego li ona o sebi. Nazovimo osobu Pero, a ‘osobnu AI asistenticu’ Betty. Betty od Pere očekuje da odobri pristup svim njegovim aktivnostima. Chat, email, pristup datotekama, kretanje, pa i prisluškivanje izravnih razgovora.

Betty će upoznati sve Perine prijatelje, gdje živi, što radi, što voli, a što ne, kuda se kreće, kad i što jede, što kupuje, koju glazbu sluša, koji su mu politički stavovi i socijalni status. Osim aplikacije na mobitelu, dodatak su i naočale koje su Perino sučelje prema Betty, ali ujedno i Bettine oči i uši. U konačnici, Betty će znati baš sve o Peri. Peri će biti primamljivo imati nekog tko ga u cijelosti poznaje, tko je uvijek uz njega, dostupan i raspoložen za razgovor, tko ga doista razumije i, bez iznimke je na njegovoj strani. Snimljen je i film na sličnu temu: ‘Her’ s fantastičnim Joaquinom Phoenixom. No, lako ćemo za SF film od prije desetak godina. Ovo je sada, i nismo u filmu.

Curenje podataka

Iznimno popularni veliki jezični modeli (large Language Models – LLM [https://en.wikipedia.org/wiki/Large_language_model] čine se kao stvarne i vrlo pametne osobe (GPT, LLama, Gemini, DeepSeek, Grok, Mistral (iz EU), Claude, Qwen, …). I nema dvojbe da imaju ogromno znanje i da mogu biti iznimno korisni. Mnogi od tih modela su open-source i njihove razne inačice se mogu preuzeti i pogoniti na vlastitoj infrastrukturi. Imati vlastiti umjetni mozak ne zvuči loše, zar ne? Ne ulazeći u tumačenje procesa strojnog učenja i produkcije AI modela, bitno je znati da su za kreaciju AI modela potrebne velike količine podataka. U slučaju velikih jezičnih modela (LLM), količina podataka je nezamislivo velika. AI modele se može do-trenirati, podešavati i destilirati (fine-tuning and distillation). Te tehnike se koriste da bi AI model dodatno naučio specifično domensko znanje ili kako bi mu se odstranile nepotrebno informacije te tako smanjila veličina i povećala točnost i fokus u području koje je od korisnikovog interesa.

Recimo da neki postupak ili poslovni proces želite unaprijediti ili ubrzati s umjetnom inteligencijom. Istražili ste više opcija i izbor je pao na neki već ugođeni (tuned) open-source [https://en.wikipedia.org/wiki/Open-source_artificial_intelligence] ‘agentic AI model[https://en.wikipedia.org/wiki/Agentic_AI]’ koji ima željene karakteristike i dovoljno je mali da ga možete pogoniti lokalno. Dali ste mu pristup vašim poslovnim podacima i sve savršeno funkcionira.

No, što ako, nakon nekog vremena, vaši podaci počnu curiti prema nepoznatoj web adresi, a da vi toga uopće niste svjesni (već je poznato da to neki AI modeli rade). To je kao da ste nepoznatu osobu pustili u svoju kuću ili tvrtku i dozvolili da, bez nadzora, radi što hoće. Drugi slučaj je kada AI model ne radi štetu namjerno. Klasični programi imaju, uz definirano okruženje, determiniran slijed izvršenja programskog koda, što kod AI sustava nije slučaj. Na isto pitanje, LLM će dati sadržajno iste, ali ne nužno identične odgovore. Ta nekonzistentnost u ponašanju je karakteristika složenih AI modela. Odstupanja mogu biti i veća (‘haluciniranje[https://en.wikipedia.org/wiki/Hallucination_(artificial_intelligence]’) a uzrok su netočni, pristrani, krivo interpretirani ili dvosmisleni podaci na osnovu kojih je AI model inicijalno kreiran ili naknadno podešavan. Takva nedosljednost u nekim situacijama može biti kritična, posebice kod agentskih AI modela koji se mogu povezivati na vanjski svijet: pristup vašim privatnim ili poslovnim podacima (bazama/datotekama), drugim servisima ili AI modelima.

Američka trivijalizacija

Zamislite da je Vaš osobni AI pomoćnik načuo Vaš razgovor u kojem ste rekli da razmišljate o kupovini novog auta. I sljedeći dan dobijete telefonski poziv iz auto salona u kojem Vas obavještavaju da možete doći po svoj auto (s najjačim opremom). Obzirom da niste imali dovoljno novca na računu, Vaš pomoćnik je kontaktirao AI model banke, podigao kredit i potom obavio online kupnju auta. Sve se ovo dogodilo samo zato što je Vaš AI pomoćnik Vašu izjavu shvatio kao naredbu koju treba izvršiti. Ovo je banalan primjer, no u praksi šteta može biti puno veća ako se dozvoli autonomnost AI modela bez kontrole.

Inicijativa za implementaciju sigurnosnih mjera, u pravilu, ne dolazi od proizvođača usluga ili proizvoda, već od zakona koji ih prisiljava na to, što u određenim slučajevima uključuje službeno testiranje i certifikaciju. To ne vrijedi samo za usluge i proizvode. U Europi, svatko tko želi voziti auto, mora najprije položiti vozački ispit, što košta i u najboljem slučaju traje dva mjeseca. Prije nego li sjednete za upravljač, morate proći zdravstveni pregled, položiti prvu pomoć i test znanja prometnih pravila. U SAD je sasvim drugačije, sve je vrlo trivijalno – u istom danu dobiješ vozačku dozvolu a sve skupa košta manje od 50 dolara. Posljedica: u SAD, prometne nesreće su najveći uzrok smrtnosti za mlade od 15 do 24 godine. Američke tvrtke žele da ista tržišna logika (Divljeg zapada) vrijedi i drugdje. Svjedoci smo nedavnog režanja američke administracije na EU zbog zabrane uvoza njihovog mesa koje ne prolazi minimalne standarde sigurnosti hrane ili ograničavanja pristupa privatnim podacima korisnika softverskih giganata.

Umjetnu inteligenciju, koja se pozicionira negdje između softvera i osobe (zbog mogućnosti autonomnog odlučivanja i djelovanja), nužno je pravno definirati, regulirati i u nekim slučajevima ograničiti, a korisnike pravno zaštiti. Nema to veze sa ‘slobodom govora’, kako nam govore kauboji; radi se jednostavno o zaštiti tvrtki, ljudi i društva u cijelosti i nije baš nikakva prepreka inovacijama i razvoju tehnologija, dapače. Pa ipak, treba imati na umu da nema tog zakona koji može nekoga spriječiti da bude glup (to doista jest sloboda izbora koju brani neki drugi zakon).

AI nije kratkotrajna pomama i njezina prisutnost u našim životima će se samo povećavati i ne možete je izbjeći. Ako imate mobitel, koristite umjetnu inteligenciju, barem indirektno. Ono što je internet bio prije 30 godina, danas je to umjetna inteligencija. Dakle, tek smo na početku.

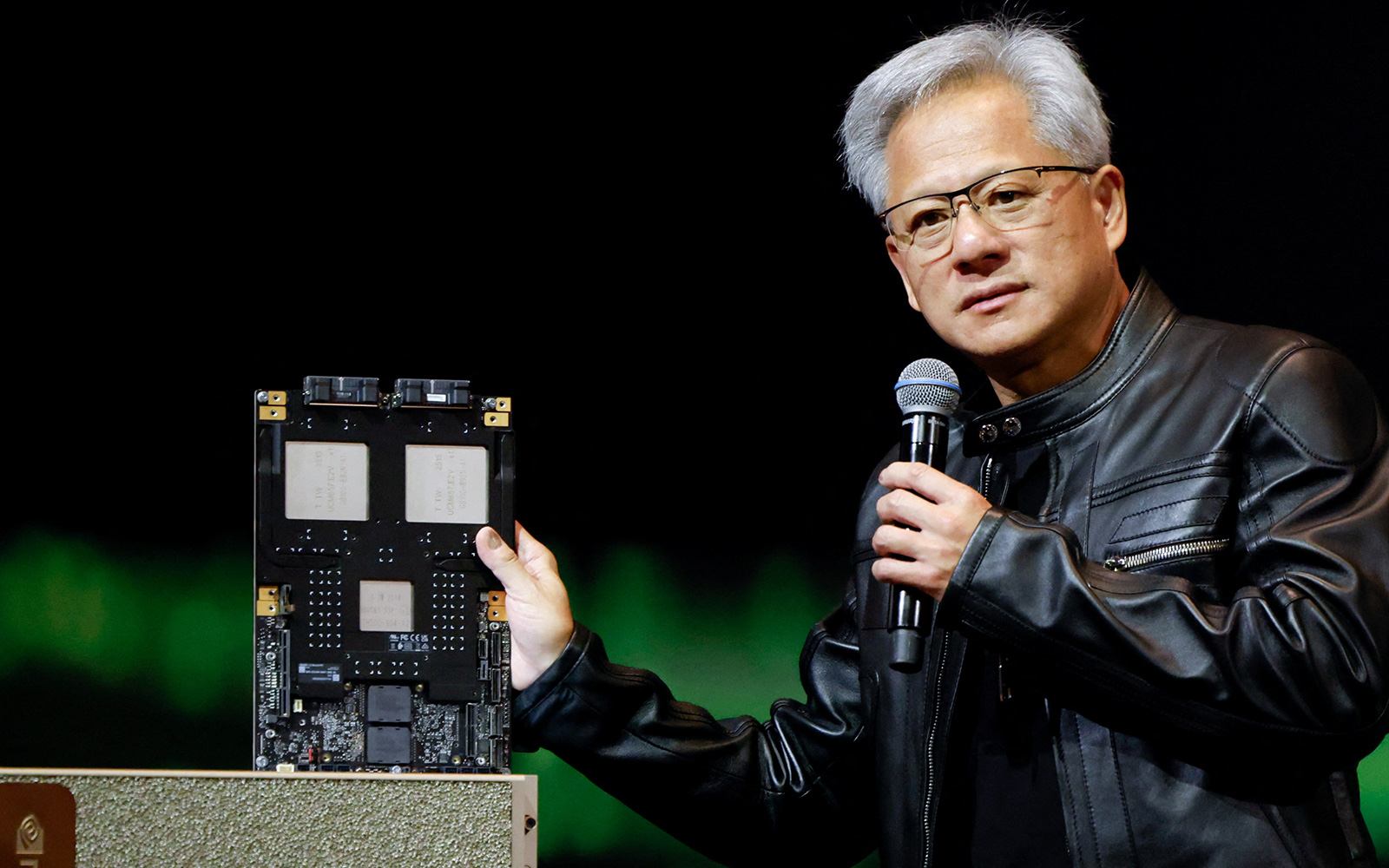

Jensen Huang, CEO Nvidije, prije nekoliko je dana izjavio: ‘Neće ti umjetna inteligencija uzeti posao, već osoba koja koristi umjetnu inteligenciju’. Stoga, naučite smisleno uposliti AI, razmislite kako možete koristiti AI za podizanje kvalitete života i unaprjeđenja na poslu, kako ubrzati ili u cijelosti automatizirati dosadne i repetitivne zadatke, ali uvijek budite u poziciji da ste vi taj koji kontrolira i upravlja umjetnom inteligencijom (human in the loop), nikada obratno.

Maliciozan – jednom

Ako koristite AI model pogonjen na vlastitoj infrastrukturi, nužno je poduzeti karantenske mjere i AI model testirati u strogo kontroliranom i izoliranom okruženju zbog rizika nepoznavanja ponašanje modela (čemu pristupa i što šalje prema van). AI model ne treba biti kontinuirano maliciozan, dovoljno je samo jednom.

Dobar primjer implementacije s umjetnom inteligencijom gdje su uzeti u obzir sigurnosni izazovi je 4qrious [https://4qrious.com] sustav. Za kraj, vratimo se našem Peri… Vrlo brzo ‘veza’ se produbila. Siroti Pero je, naposljetku, ipak samo čovjek sa svim ljudskim slabostima. Vezao se za Betty do te mjere da je spreman učiniti sve za ‘nju’. Ne želeći ništa skrivati od svoje družice, odobrio joj je pristup svim svojim podacima i autonomno djelovanje. I, ne zaboravimo, s Betty u cijelosti upravlja Meta, Google, ili … tko zna? Opreza nikad dosta, i zato: (ne umjetnu) pamet u glavu.

*Napomena: unutar zagrada [] je web link za prethodnu riječ koja je trentačno prisutna u web izdanju.