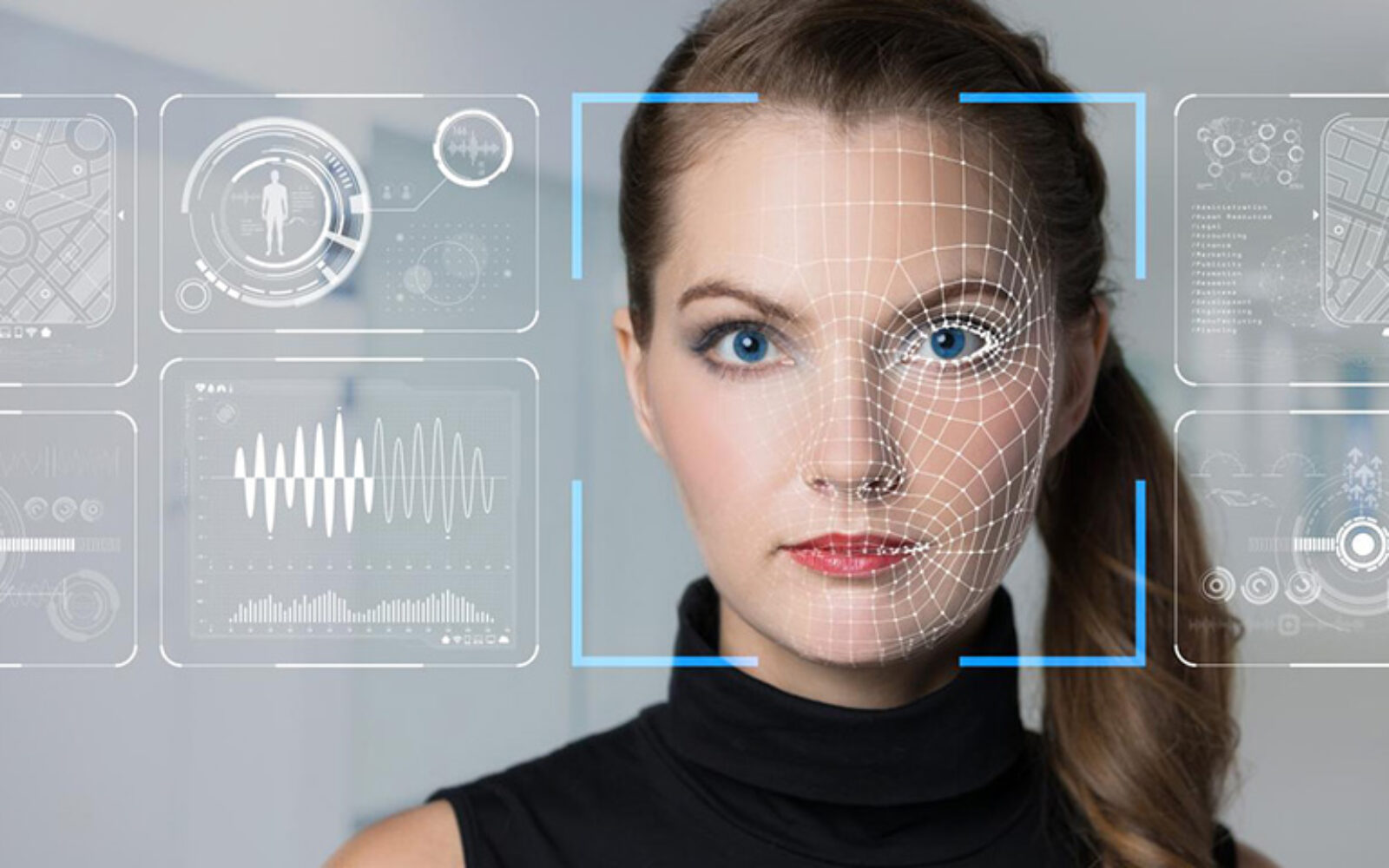

U Poznanu, 325 kilometara istočno od Varšave, tim tehnoloških istraživača, inženjera i skrbnika djece radi na maloj revoluciji. Njihov zajednički projekt, ‘Insension’, koristi se prepoznavanjem lica koje pokreće umjetna inteligencija (AI) kako bi se pomoglo djeci s dubokim intelektualnim i višestrukim poteškoćama u interakciji s drugima i okolinom, čime postaju povezanija sa svijetom.

To je dokaz snage te tehnologije koja brzo napreduje. Tisućama kilometara dalje, na ulicama Pekinga, državni dužnosnici koriste se prepoznavanjem lica pogonjenim AI-jem kako bi pratili svakodnevno kretanje građana i držali cjelokupno stanovništvo pod strogim nadzorom.

Važna obavijest:

Sukladno članku 94. Zakona o elektroničkim medijima, komentiranje članaka na web portalu Poslovni.hr dopušteno je samo registriranim korisnicima. Svaki korisnik koji želi komentirati članke obvezan je prethodno se upoznati s Pravilima komentiranja na web portalu Poslovni.hr te sa zabranama propisanim stavkom 2. članka 94. Zakona.Uključite se u raspravu